Statistics / Machine Learning

통계학, 머신러닝 목차 새로 정리하기

Bayesian Inference

mcmc

time series

class imbalance

인공지능이 현실세계 데이터를 만났을 때 나타날 고민거리 http://m.itdaily.kr/news/articleView.html?idxno=100487

self-supervised learning

XAI

Machine Learning

«Doing Data Science»

모형 : 건축적이든 생물학적이든 혹은 수학적이든, 그것은 하나의 특정한 렌즈를 통해 현실의 성격을 이해하려고 표현하는 시도

EDA는 우리가 존재한다고 믿는 것들은 물론이고 존재하지 않는다고 믿는 것들을 발견하려는 태도, 유연성, 그리고 자발성 - John Tukey -

(↔ Confirmatory data analysis)

EDA는 도구인 것만큼이나 사고방식이기도 하다.

EDA 참고문헌 목록

Algorithm

1) data engineering : sort, map reduce, pregel 등 데이터 변환, 사전준비, 처리 알고리즘

2) optimization algorithm : stochastic gradient descent, Newton's method, least squere 등

3) machine learning algorithm

Feature

WoE : Weight of Evidence

$WoE_{x=i}$ = $\log({\text{% of y=0 when x=i}\over\text{% of y=1 when x=i}})$ = $\log({\text{distribution of Goods}\over\text{distribution of Bads}})$

- 둘이 같은 비율이라면 0이 될 것이고

로그 특성상

1. 단조 증가

2. x 가 1 미만에선 기울기가 급강하해서 오히려 event 에 민감하게 반응하는 효과가 있다..

- IV와 WOE 신용채무능력이 가능한(good) 고객과 불가능한(bad) 고객을 예측하는 로지스틱 회귀 모델링과 밀접한 관계가 있다. 신용 정보 관련분야에서는 good customer는 부채를 갚을 수 있는 고객, bad customer는 부채를 갚을 수 없는 고객을 뜻한다. 일반적으로 이야기할 때는 good customer는 non-events를 의미하고 bad customer는 events를 의미한다.

https://tkdguq05.github.io/2019/04/25/Fearuture-Selection-Information-Value/

https://velog.io/@soonwoo2003/WoE-%EC%99%80-IV-Weight-of-Evidence-Info.-Value-1

- Combine categories with similar WOE and then create new categories of an independent variable with continuous WOE values.

https://www.listendata.com/2015/03/weight-of-evidence-woe-and-information.html#:~:text=Weight%20of%20Evidence%20(WOE)%20helps,of%20events%20and%20non%2Devents.

Information Value (IV)

IV = $\sum $ (% of non-events - % of events) * WOE

- Random forest can detect non-linear relationship very well so selecting variables via Information Value and using them in random forest model might not produce the most accurate and robust predictive model.

비교

IS-163 국내 기업의 디지털 전환 촉진을 위한 주요 요인 도출 및 실증 연구_v20230818-03 1.pdf

종속변수가 명목형이기 때문에 Spearman 상관분석 방법 채택

- Spearman 상관분석은 주요 요인 한정(限定) 및 요인 간 상대적 중요도 비교가 어려움

- 11개의 독립변수 중 1개를 제외한 10개의 변수가 통계적으로 유의한 상황에서 디지털 전환 촉진 주요 요인이 되기 위한 상관계수 절대값 기준을 세우기 힘듦 (연구자의 자의적 판단 필요)

- 요인(독립변수) 간 단위가 상이하여 상관계수값으로 요인 간 상대적 중요도를 비교하기에는 적절치 않음

이항 로지스틱 회귀분석을 통해 디지털 전환 촉진 요인 간 상대적 중요도 비교는 가능하나, 주요 요인 한정(限定)은 어려움

- 이항 로지스틱 회귀분석 결과인 표준화된 회귀계수 절대값을 이용하여 요인(독립변수) 간 상대적 중요도 비교는 가능

- 그러나, 주요 요인을 한정하기 위한 표준화된 회귀계수 절대값의 기준 설정이 어려워 연구자의 자의적 판단 필요

랜덤포레스트 알고리즘을 통해 주요 요인 간 상대적 중요도 비교는 어느 정도 가능하나, 선정된 요인의 디지털 전환 정(+) 또는 부(-) 영향구분 및 주요 요인 한정(限定)은 어려움

- 랜덤포레스트 알고리즘 수행 결과인 요인(독립변수)별 MDA 값을 이용하여 요인 간 상대적 중요도 비교 가능

- 그러나, 랜덤포레스트 알고리즘 수행 시마다 MDA 값이 변하기 때문에 요인 간 상대적 중요도에 차이가 발생하고 상대적 중요도 순위가 바뀔 수 있음 (fluctuation 특성)

- 선정된 요인이 디지털 전환 추진 여부에 정(+) 또는 부(-)의 영향인지 MDA값만으로 구분하기 어려움

- 또한, 주요 요인을 한정하기 위한 MDA 기준 설정이 어려워 연구자의 자의적 판단 필요

보루타 알고리즘은 랜덤포레스트를 래핑(wrapping)한 방식으로, 랜덤포레스트와 달리 판별 모형 생성에 영향을 주지 못하는 변수를 제외시키고 통계 기법을 통해 주요 요인의 상대적 중요도 확정

- 보루타 알고리즘은 Shadow feature를 추가하여 판별 모형 생성 시 영향을 주는 주요 요인 변수와 영향을 주지 않는 변수 구분

- 기존 랜덤포레스트 알고리즘의 fluctuation 한계를 극복하기 위해 보루타 알고리즘은 통계적인 방법(z-score)을 사용하여 독립변수별 상대적 중요도 확정

보루타 알고리즘은 주요 요인 선정 기준을 제시할 수 있고 요인 간 상대적 중요도도 비교 가능하나, 선정된 요인이 디지털 전환 추진 여부에 정(+) 또는 부(-)의 영향을 주는지 구분하기는 어려움

- 보루타 알고리즘의 shadow feature는 주요 요인 여부를 명확히 구분해 주고, 중요도(Importance)값은 독립변수 간 상대적 중요도의 비교를 가능케 함

- 그러나, 중요도값만으로는 선정된 요인이 디지털 전환 추진 여부에 정(+) 또는 부(-)의 영향을 주는지 구분하기 어려움

디지털 전환 촉진에 영향을 주는 주요 요인을 도출하기 위해 사용된 4가지 분석 방법의 특성 비교 (표 12)

- (Spearman 상관분석) 촉진 요인을 선정하기 위한 기준 제시가 어렵고 요인 간 상대적 중요도를 비교할 수 없으나, 디지털 전환에 대한 요인의 정(+) 또는 부(-) 상관관계는 제시

- (이항 로지스틱 회귀분석) 촉진 요인을 선정하기 위한 기준을 제시하기 어려우나, 요인 간 상대적 중요도 비교는 가능하고 요인의 회귀계수 부호로 디지털 전환의 정(+) 또는 부(-) 영향 구분 가능

- (랜덤포레스트) 촉진 요인을 선정하기 위한 기준 제시가 어렵고 디지털 전환에 대한 요인의 정(+) 또는 부(-) 영향 구분은 어렵지만, 요인 간 상대적 중요도는 어느 정도 비교 가능 (알고리즘 임의성으로 인해 상대적중요도가 매번 변함)

- (보루타 알고리즘) 디지털 전환에 대한 요인의 정(+) 또는 부(-) 영향 구분은 어렵지만, 주요 요인을 선정하기 위한 기준을 제시할 수 있고 요인 간 상대적 중요도도 비교 가능

BORUTA 알고리즘

https://hongl.tistory.com/112

BORUTA의 첫 번째 스텝은 각 변수 (X)를 복사하고 복사된 변수 열을 예측 변수와 관계를 없애기 위해 랜덤하게 섞은 shadow features 를 만드는 것입니다. Shadow features 를 만들고 원래 feature 와 붙인 뒤에 feature importance를 알 수 있는 의사결정나무 기반의 Random forest, XGBoost 등의 모델로 훈련시켜 shadow features 의 feature importance 보다 작은 importance 를 가지는 본래 feature를 제거하자는 원리입니다.

1) 모든 변수들을 복사합니다.

2) 복사한 변수 (tabular 데이터에서의 column)를 타겟에 uncorrelated 하게 만들기 위해 랜덤하게 섞습니다. (permute)

3) 원래 features와 1,2 과정을 거친 shadow features를 합칩니다. (concat)

4) Feature importance를 잴 수 있는 의사결정나무 기반의 Random forest나 XGBoost 등의 모델을 활용하여 학습합니다.

5) 학습 결과 나온 feature importance를 기반으로 shadow features의 가장 큰 feature importance를 임계치로 잡아 이보다 작은 importance를 가진 feature를 중요하지 않다고 분류합니다.

6) 1-5의 과정을 반복하여 통계적으로 유의미한 결과를 얻을 수 있도록 합니다.

ISLR

2 Statistical Learning

2.1 What Is Statistical Learning?

$$ Y = f(X) + \epsilon $$

2.1.1 Why Estimate f?

두가지 주요한 이유는 예측과 추론

- 예측 : $ E(Y-\hat{Y})^2 = E[f(X)+\epsilon-\hat{f}(X)]^2 = [f(X)-\hat{f}(X)]^2 + Var(\epsilon) $

- 첫항은 줄일 수 있음. Var는 없앨 수 없음.

- 추론이 목적일 때는 좀 덜 유연한 방법이 장점이 있음

2.1.2 How Do We Estimate f?

parametric / non-parametric

2.1.3 The Trade-Off Between Prediction Accuracy and Model Interpretability

2.1.4 Supervised Versus Unsupervised Learning

2.1.5 Regression Versus Classification Problems

2.2 Assessing Model Accuracy

모든 데이터에 dominent한 모형, 방법은 없음

2.2.1 Measuring the Quality of Fit

MSE(Mean squared error) = $ {{1}\over{n}} \sum(y_i-\hat{f}(x_i))^2 $

overfitting : training 말고 test set에 대한 MSE가 중요

2.2.2 The Bias-Variance Trade-Off

test MSE 곡선이 U-curve 보이는 것

$$ E(y_{test}-\hat{f}(x_{test}))^2 = Var(\hat{f}(x_{test})) + [ Bias( \hat{f}(x_{test}) )]^2 + Var(\epsilon) $$

유도

2.2.3 The Classification Setting

test error rate = $ Ave( I(y_{test} \neq \hat{y}_{test}) ) $

3 Linear Regression 59

3.1 Simple Linear Regression

3.1.1 Estimating the Coefficients

OLS vs Orthogonal distance

https://stats.stackexchange.com/questions/319041/why-does-linear-regression-use-a-cost-function-based-on-the-vertical-distance-be

3.1.2 Assessing the Accuracy of the Coefficient Estimates

3.1.3 Assessing the Accuracy of the Model

SLR에서는 $ R^2 = r^2 $

$ R^2 =1- {\text{Unexplained Variation}\over\text{Total Variation}} $

3.2 Multiple Linear Regression

3.2.1 Estimating the Regression Coefficients

3.2.2 Some Important Questions

Mallows Cp, AIC, BIC, Adjusted R^2

3.3 Other Considerations in the Regression Model

3.3.1 Qualitative Predictors

3.3.2 Extensions of the Linear Model

가장 중요한 가정 중 두가지는 Additive 및 Linear Relation 이라는 것.

- 가산성 가정 제거 interaction

- polynomial

3.3.3 Potential Problems . . . . . . . . . . . . . . . . . . . 92

non-linearity

error들의 상관성

error의 non-constanct 분산 :

- $ log Y $ 또는 $ \sqrt{Y} $ 같은 concave 함수를 사용하여 변환하면 조금 나아짐

- weighted least square

outlier

- residual plot, studentized residuals 하면 더 잘 보임

leverage가 높은(영향력이 큰) 관측치

- outlier는 y가 다른 것, leverage는 x가 다른 것

- Leverage $ h_i $ = $ {1\over n} + {(x_i-\bar{x})^2 \over {\sum(x_i-\bar{x})^2} } $

- 모든 관측치의 평균 Leverage는 (p+1)/n → 관측치가 이보다 큰 통계량을 가지면 높은 leverage 가진다고 의심 가능

공선성Collinearity

VIF, 경험적으로 5 or 10을 초과하는 VIF값은 문제가 있다

4 Classification 127

4.1 An Overview of Classification . . . . . . . . . . . . . . . . . 128

Probability Calibration

진짜 확률이 맞나?

- Logistic Regression 은 p가 모형에 들어가므로 맞음

- 다른 일반적인 모형들은 Frequentists 입장에서는 아님

: an event’s probability is the limit of its relative frequency in many trials

: threshold로서는 적합하지만 probability로서는 글쎄?

- 대부분 모형들은 과추정하게 됨 (0 or 1) : Calibration curve 를 통해 확인

- 실제 Data에서의 발생빈도에 맞게 Calibration할 필요가 있음

- Logistic Regression과 비교(Platt-scaling) 등

https://towardsdatascience.com/calibrating-classifiers-559abc30711a

https://gdmarmerola.github.io/probability-calibration/

https://kiwidamien.github.io/are-you-sure-thats-a-probability.html

https://gdmarmerola.github.io/probability-calibration/

https://www.cs.cornell.edu/~alexn/papers/calibration.icml05.crc.rev3.pdf

4.2 Why Not Linear Regression?

일반적으로는 Level 3이상인 질적 반응변수를 선형회귀를 위해 양적 반응변수로 변경하는 자연스러운 방법은 없다.

[0,1] 범위를 벗어나서 확률로 해석하기 어려움ㅁ

그럼에도 예측값은 어떤 순서를 제공하고 대충 확률 추정치로 해석될 수 있음. 신기하게도, 이진 반응변수 예측을 위해 선형회귀를 사용하는 경우 얻게 되는 분류는 LDA(Linear Discriminant Analysis)의 결과와 동일

4.3 Logistic Regression . . . . . . . . . . . . . . . . . . . . . . . 130

- Continuous Ratio : Beta Regression

https://stats.stackexchange.com/questions/29038/regression-for-an-outcome-ratio-or-fraction-between-0-and-1

Let me make a quick clarification. I interpret the question as being about the ratio of two, positive, real values. If so, (and they are distributed as Gammas) that is a Beta distribution. However, if a is a count of 'successes' out of a known total, b, of 'trials', then this would be a count proportion a/b, not a continuous proportion, and you should use binomial GLM (e.g., logistic regression).

https://stats.stackexchange.com/questions/259131/what-is-the-relationship-between-the-beta-distribution-and-the-logistic-regressi

Beta is a distribution of values in (0,1) range that is very flexible in it's shape, so for almost any unimodal empirical distribution of values in (0,1) you can easily find parameters of such beta distribution that “resembles” shape of the distribution.

Notice that logistic regression provides you with conditional probabilities Pr(Y=1∣X), while on your plot you are presenting us the marginal distribution of predicted probabilities. Those are two different things to talk about.

https://stackoverflow.com/questions/56316514/beta-regression-vs-linear-regression-for-strictly-bounded-outcome-variable-0-1

You can apply a sigmoid function to the output of the linear regression (this is called “logistic regression”), but this will model a binary variable and give you the probability of the variable being 1. In your case, your variable isn't binary, it can have any value between 0 and 1. For that problem, you need to apply a beta regression, which will give you a bounded output between 0 and 1.

4.3.1 The Logistic Model . . . . . . . . . . . . . . . . . . . 131

4.3.2 Estimating the Regression Coefficients . . . . . . . . 133

MLE, no closed form

선형회귀에서 Least Square 는 사실상 MLE의 특별한 경우

4.3.3 Making Predictions . . . . . . . . . . . . . . . . . . . 134

4.3.4 Multiple Logistic Regression . . . . . . . . . . . . . . 135

Confounding : 선형회귀에서와 같이 하나의 설명변수를 사용하여 얻은 결과는 다수의 설명변수를 사용하여 얻은 결과와 상당히 다를 수 있다.

4.3.5 Logistic Regression for >2 Response Classes . . . . . 137

확장 가능

But, discriminant analysis 방법이 다중 클래스 분류에 일반적으로 사용되기 때문.

4.4 Linear Discriminant Analysis

important box

- 클래스들이 잘 분리될 때 LR에 대한 모수 추정치는 아주 불안정.

- n이 작고 각 클래스에서 설명변수 X의 분포가 근사적으로 정규분포이면 LDA가 LR보다 더 안정적

- 반응변수의 클래스 수가 2보다 클 때 일반적으로 사용됨

4.4.1 Using Bayes’ Theorem for Classification . . . . . . . 138

4.4.2 Linear Discriminant Analysis for p = 1 . . . . . . . . 139

4.4.3 Linear Discriminant Analysis for p >1 . . . . . . . . 142

4.4.4 Quadratic Discriminant Analysis . . . . . . . . . . . 149

4.5 A Comparison of Classification Methods . . . . . . . . . . . 151

important box

k-NN[1]

1) similarity 정의

2) 몇 개의 이웃? k

Euclidean : 단위가 동일하다는 가정, 때로는 매우 강력한 가정일 수 있다

Cosine similarity : 벡터 방향

Jaccard distance : 집합의 유사도

Mahalanobis distance : 유클리드에 비해 상관을 고려할 수 있고 단위와 무관. covariance 행렬

Hamming distance : 문자의 위치가 같은지, 문자열,단어,DNA 서열 간 거리

Mangattan distance : 격자 모양

5 Resampling Methods 175

5.1 Cross-Validation . . . . . . . . . . . . . . . . . . . . . . . . 176

5.1.1 The Validation Set Approach . . . . . . . . . . . . . 176

training set / validation set

5.1.2 Leave-One-Out Cross-Validation . . . . . . . . . . . 178

leave one out → MSE 평균

- bias가 적다. 전체 데이터의 관측치 수와 거의 같은 n-1개 관측치의 training data.

- 여러번 수행해도 같은 결과

LR일 경우, 계산시간이 하나의 모델 적합과 동일하게 되도록 하는 방법

$ CV_{(n)} = {1 \over n} \sum \left( {y_i-\hat{y}_i} \over {1-h_i} \right)^2 $ , $ h_i = {1 \over n} + {{(x_i+\bar{x})^2}\over{\sum(x_i-\bar{x})^2}} $ : Leverage

5.1.3 k-Fold Cross-Validation . . . . . . . . . . . . . . . . 181

LOOCV 는 k=n 인 특별한 경우: n>k → 계산량

목적

- 주어진 학습절차가 데이터에 대해 얼마나 잘 수행되는지 : MSE의 실질적인 추정치

- 다수 학습방법 or 하나 학습방법 내의 다른 수준의 유연성(U자 그래프 형태) : MSE 최소값의 위치

5.1.4 Bias-Variance Trade-Off for k-Fold Cross-Validation

LOOCV보다 검정오차율을 더 정확하게 추정 : variance-bias trade-off

일반적으로 k= 5 or 10 : 지나치게 높은 bias와 높은 variance 로 인한 문제없이 검정오차율 추정치를 얻을 수 있다는 것이 경험적으로 알려져 있기 때문

5.1.5 Cross-Validation on Classification Problems . . . . . 184

5.2 The Bootstrap . . . . . . . . . . . . . . . . . . . . . . . . . 187

important box

6 Linear Model Selection and Regularization

- 예측 정확도 : n이 p보다 아주 크지 않을 때 LSE에 많은 변동이 존재할 수 있어 과적합 초래, p > n 이면 unique Estimator가 존재X

- 모델 해석력 : 변수선택

6.1 Subset Selection . . . . . . . . . . . . . . . . . . . . . . . . 205

6.1.1 Best Subset Selection . . . . . . . . . . . . . . . . . 205

계산 문제..

6.1.2 Stepwise Selection . . . . . . . . . . . . . . . . . . . 207

6.1.3 Choosing the Optimal Model . . . . . . . . . . . . . 210

1. 과적합으로 인한 편향을 고려하도록 훈련오차를 adjustment 하여 검정오차를 간접적으로 추정 (MSE = RSS / n)

training MSE는 일반적으로 validation MSE를 과소추정

$ C_p = {1\over n} ( RSS + 2d\hat{\sigma}^2 ) $ , d: LSE 설명변수 수, 2d\sigma panelty

$ AIC = {1\over{n\hat{\sigma}^2}}(RSS+2d\hat{\sigma}^2) $ MLE 적합 모델

$ BIC = {1\over n} ( RSS + log(n)d\hat{\sigma}^2 ) $

$ Adjusted R^2 = 1 - { {RSS/(n-d-1)} \over {TSS/(n-1)} } $ 다른 것과 달리 클수록 검정오차가 작다.

- 올바른 변수들이 모두 모델에 포함되고 나면 추가로 noise 변수를 포함하는 것은 RSS를 아주 조금밖에 감소시키지 않을 것이라는 것.

2. Cross-Validation

6.2 Shrinkage Methods

6.2.1 Ridge Regression

6.2.2 The Lasso

6.3 Dimension Reduction Methods . . . . . . . . . . . . . . . . 228

1) trasformed variable $ Z_m = \sum^p_j \phi_{jm}X_j $

2) M개의 설명변수를 사용해 모델을 적합

6.3.1 Principal Components Regression . . . . . . . . . . . 230

first principal component의 방향은 관측치들이 가장 크게 변화하는(변동이 가장 큰) 방향

first principal vector는 데이터에 가능한 한 가까운 직선 (수직거리의 제곱합을 최소로 함)

PCR (principal components regression) : 적은 수의 주성분들이면 데이터 내 대부분의 변동과 반응변수의 상관관계를 설명하는 데 충분하다.

변수선택방법은 아님. 사용되는 M개의 주성분 각각은 원래의 p개 변수 모두로 구성된 선형결합이기 때문

이런 의미에서 lasso보다 ridge에 더 밀접하게 관련 (사실 밀접하게 관련되어 있음. 심지어 ridge는 PCR의 continuous 버전으로 생각할 수 있음)

M은 CV를 통해

주성분 생성 전에 standardizing하는 것이 일반적으로 권장. 표준화하지 않을 경우, 분산이 높은 변수들이 얻어진 주성분에서 더 큰 역할을 하는 경향.

하지만 변수들이 모두 동일한 단위(ex. Kg, inch..) 로 측정되면 않을 수도 있음

unsupervised 방식.

6.3.2 Partial Least Squares . . . . . . . . . . . . . . . . . 237

PLS.

supervised 방식

반응변수와 설명변수 모두를 설명하는 데 도움이 되는 방향을 찾고자 하는 것.

- p개의 설명변수들을 표준화

- $ Z_m = \sum^p_j \phi_{jm}X_j $ 에서 $ \phi_{j1} $ 각각을 Y의 X_j 에 대한 단순선형회귀 계수와 동일하게 설정하여 첫 번째 방향 Z_1을 계산

- 이 계수는 Y와 X_j 사이의 상관계수에 비례 → 반응변수와 가장 강하게 관련되어 있는 변수들에 가장 높은 가중치 부여

- 두번째 방향을 식별하기 위해 Z_1 에 대해 각 변수의 회귀를 수행, 잔차를 취하여 변수 각각을 Z_1에 대해 먼저 조정

- 이 잔차들은 첫번째 PLS 방향에 의해 설명되지 않고 남아있는 정보로 해석될 수 있음

- 원래의 데이터를 기반으로 Z_1을 계산했던 것과 완전히 동일한 방식으로 Z_2가 '이 직교화된 데이터'(잔차)를 사용하여 계산됨

PLS는 디지털화된 분광분석(spectrometry) 신호들로부터 많은 변수들이 발생되는 계량분석화학(chemometrics) 분야에서 널리 사용.

실질적으로 PLS는 보통 ridge나 PCR과 비슷한 성능. 편향을 줄일수 있지만 반면에 분산을 증가시킬 가능성. PCR과 비교해서 특별한 잇점은 X

6.4 Considerations in High Dimensions . . . . . . . . . . . . . . 238

6.4.1 High-Dimensional Data . . . . . . . . . . . . . . . . 238

6.4.2 What Goes Wrong in High Dimensions? . . . . . . . 239

p가 n만큼 크거나 n보다 클 때, LSE 할 수 없음. 데이터에 완벽하게 적합되어 잔차들이 0인 계수 추정치들의 집할을 제공할 것

(ex. n=2 일 때 절편과 기울기(p=2) 를 추정하는 경우)

유감스럽게도 $ C_p $, AIC, BIC 기법들은 $ \hat{\sigma}^2 $ 추정에 문제의 소지가 있어 고차원 설정에 적합하지 않음.( $ \approx 0 $ )

R^2도 1인 모델을 쉽게 얻을 수 있으므로 adjusted 도 적용하는데 문제

6.4.3 Regression in High Dimensions . . . . . . . . . . . . 241

1) regularization 또는 shrinkage 는 고차원 문제에서 핵심적 역할

2) 적절한 hyperparameter 선택은 좋은 예측성능을 얻는 데 있어서 아주 중요

3) 관계 있는 변수 선택이 중요

심지어 변수들이 문제와 관련이 있더라도 계수들을 적합할 때 발생되는 분산이 이 변수들로 인한 편향 감소의 잇점을 완전히 상쇄할 수도 있다.

6.4.4 Interpreting Results in High Dimensions . . . . . . . 243

고차원 설정에서 multicollinearity 가 아주 심각한 문제가 될 수 있음

근본적으로 어느 변수들이 결과 예측에 실제로 관련이 있는지 결코 정확하게 알 수 없고, 회귀에서 사용할 가장 좋은 계수들을 결코 식별할 수 없음을 의미.

고차원 설정에서는 RSS, p-value, R^2 또는 다른 전통적인 measure를 모델적합이 좋다는 증거로 결코 사용해서는 안됨.

(p>n일 때 R^2 = 1 인 모델을 쉽게 얻을 수 있음)

대신에 독립적인 validation set에 대한 결과나 교차검증 오차를 알리는 것은 중요

독립적인 validation set에 대한 MSE나 R^2은 모델적합에 대한 유효한 측도이지만, 훈련셋에 대한 MSE는 확실히 그렇지 않음

7 Moving Beyond Linearity 265

7.1 Polynomial Regression 266

7.2 Step Functions 268

조각별piecewise 상수constant회귀모델

$ C_{k-1}(X) = I(c_{k-1} \leq X < c_k) $, $ y_i = \sum \beta_k C_k(x_i) $

7.3 Basis Functions . . . . . . . . . . . . . . . . . . . . . . . . . 270

다항식 및 조각별 상수회귀모델들은 basis function 기법의 특별한 경우

LSE : 선형모델들에 대한 모든 추론도구들을 이 설정에서 사용할 수 있다는 것.

wavelet, Fourier Series

7.4 Regression Splines 271

7.4.1 Piecewise Polynomials . . . . . . . . . . . . . . . . . 271

$ y_i = \begin{cases} \sum \beta_{i1}x_i,& \text{if } x_i < c \\ \sum \beta_{i2}x_i,& \text{if } x_i \geq c \end{cases} $

함수가 연속적이지 않게 됨 : 자유도 p+p = 2p

7.4.2 Constraints and Splines . . . . . . . . . . . . . . . . 271

cubic spline (3차)

자유도 8 → 제약조건 (연속성, 1차 도함수 연속성, 2차 도함수 연속성) 추가 : 자유도5

K개의 매듭(knots, 계수들이 변하는 점)의 삼차 스플라인은 총 4+K 의 자유도

(삼차 스플라인이 널리 사용되는데, 그 이유는 사람 눈은 대부분 매듭에서의 불연속성을 알아채지 못하기 때문)

7.4.3 The Spline Basis Representation . . . . . . . . . . . 273

$ X, X^2, X^3, h(X, \xi_1), h(X, \xi_2), h(X, \xi_3) $ 형태의 3+K개 설명변수 LSE. $ \xi_i $ 는 knots

$ h(X, \xi) = (x-\xi)^3_+ = (x-\xi)^3, \text{if } x > \xi, 0 \text{otherwise} $

7.4.4 Choosing the Number and Locations of the Knots . . . . . . . . . . . . . . . . . . . . . . 274

7.4.5 Comparison to Polynomial Regression . . . . . . . . 276

다항식은 유연한 적합을 위해 높은 차수를 사용해야 하지만, 스플라인은 차수는 고정시키고 knots 수를 증가시켜 유연성을 높일 수 있음

7.5 Smoothing Splines 277

7.5.1 An Overview of Smoothing Splines . . . . . . . . . . 277

스플라인을 생성하는 약간 다른 방법

$ \sum(y_i - g(x_i) )^2 + \lambda \int g''(t)^2 dt $ 을 minimize, penalty 없으면 yi를 그냥 따라가면 됨, $ \lambda \rightarrow \infty $ 면 사실상 선형 최소제곱선

2차 도함수 : 기울기가 변하는 정도, roughness의 측도 → integral : 전 범위에 걸쳐 $ g'(t) $의 총 변화에 대한 측도

위의 삼차 스플라인과는 다르지만, 모든 $ x_i $에 knot이 있는 shrunken 버전의 자연 삼차 스플라인.

7.5.2 Choosing the Smoothing Parameter λ . . . . . . . . 278

7.6 Local Regression 280

목표점 x_0 에서 그 주변의 훈련 관측치들만 사용하여 적합을 계산

memory-based : kNN 같이 계산할 때마다 모든 훈련 데이터를 필요로 함

7.7 Generalized Additive Models 282

7.1-7.6은 단일 설명변수 X : 단순선형회귀의 확장

여러개의 설명변수 X_1,…X_p 를 기반.

$ y_i = \beta_0 + \beta_1 x_{i1} + \beta_2 x_{i2} + \ldots + \epsilon_i $

확장 ⇒ $ y_i = \beta_0 + f_1(x_{i1}) + f_2(x_{i2}) + \ldots + \epsilon_i $

각 X_j에 대해 변도로 f_j 를 계산하고 이들의 기여를 모두 더하기 때문에 additive model 이라고 불림

선형모델과 완전 비모수적 모델 사이에서의 절충

8 Tree-Based Methods 303

8.1 The Basics of Decision Trees . . . . . . . . . . . . . . . . . 303

8.1.1 Regression Trees . . . . . . . . . . . . . . . . . . . . 304

8.1.2 Classification Trees . . . . . . . . . . . . . . . . . . . 311

8.1.3 Trees Versus Linear Models . . . . . . . . . . . . . . 314

8.1.4 Advantages and Disadvantages of Trees . . . . . . . 315

8.2 Bagging, Random Forests, Boosting . . . . . . . . . . . . . 316

8.2.1 Bagging . . . . . . . . . . . . . . . . . . . . . . . . . 316

8.2.2 Random Forests . . . . . . . . . . . . . . . . . . . . 319

8.2.3 Boosting . . . . . . . . . . . . . . . . . . . . . . . . . 321

다른 점은 트리들이 순차적으로 만들어진다는 것.

각 트리는 이전에 만들어진 트리들로부터 정보를 사용하여 만들어짐.

bootstrap 샘플링 하지 않고, 각 트리는 수정된 버전의 원래 데이터셋에 적합됨

boosting for regression tree

$ \hat{f}(x) = 0, r_i = y_i $ → for each b in B, $ \hat{f}^b(x) $ 적합 (d개 분할, d+1개 터미널 노드) → $ \hat{f}(x) \leftarrow \hat{f}(x) + \lambda \hat{f}^b(x) $, $ r_i \leftarrow - \lambda\hat{f}^b(x) $ 업데이트

$ \hat{f}(x) = \sum_{B} \lambda \hat{f}^b(x) $

트리수 B : RF와 달리 너무 크면 과적합 가능성, CV로..

$ \lambda $ : 학습 속도 제어, 0.01 or 0.001

d : boosting ensemble의 복잡도 제어 보통 d=1 이면 잘 동작.

9 Support Vector Machines 337

9.1 Maximal Margin Classifier . . . . . . . . . . . . . . . . . . . 338

9.1.1 What Is a Hyperplane? . . . . . . . . . . . . . . . . 338

9.1.2 Classification Using a Separating Hyperplane . . . . 339

9.1.3 The Maximal Margin Classifier . . . . . . . . . . . . 341

9.1.4 Construction of the Maximal Margin Classifier . . . 342

9.1.5 The Non-separable Case . . . . . . . . . . . . . . . . 343

9.2 Support Vector Classifiers . . . . . . . . . . . . . . . . . . . 344

9.2.1 Overview of the Support Vector Classifier . . . . . . 344

9.2.2 Details of the Support Vector Classifier . . . . . . . 345

9.3 Support Vector Machines . . . . . . . . . . . . . . . . . . . 349

9.3.1 Classification with Non-linear Decision

Boundaries . . . . . . . . . . . . . . . . . . . . . . . 349

9.3.2 The Support Vector Machine . . . . . . . . . . . . . 350

9.3.3 An Application to the Heart Disease Data . . . . . . 354

9.4 SVMs with More than Two Classes . . . . . . . . . . . . . . 355

9.4.1 One-Versus-One Classification . . . . . . . . . . . . . 355

9.4.2 One-Versus-All Classification . . . . . . . . . . . . . 356

9.5 Relationship to Logistic Regression . . . . . . . . . . . . . . 356

9.6 Lab: Support Vector Machines . . . . . . . . . . . . . . . . 359

9.6.1 Support Vector Classifier . . . . . . . . . . . . . . . 359

9.6.2 Support Vector Machine . . . . . . . . . . . . . . . . 363

9.6.3 ROC Curves . . . . . . . . . . . . . . . . . . . . . . 365

9.6.4 SVM with Multiple Classes . . . . . . . . . . . . . . 366

9.6.5 Application to Gene Expression Data . . . . . . . . 366

9.7 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . 368

10 Unsupervised Learning 373

10.1 The Challenge of Unsupervised Learning . . . . . . . . . . . 373

실제 답을 모르기 때문에 점검할 방법이 없다.

10.2 Principal Components Analysis

주성분들을 계산하는 과정과, 그후 데이터를 이해하는 데 이 주성분들을 사용하는 것.

지도학습에 사용하기 위한 파생변수(derived variable)들을 생성하는 것, 데이터 시각화를 위한 도구로서도 사용

matrix thing

PCA

10.3 Clustering Methods

10.3.1 K-Means Clustering

k-means 문제점[1]

k 값 선택 : 비과학적

수렴 : loop에 빠져서 두 개의 가능해 사이를 왔다 갔다 할 경우

해석 : 어떤 경우 정답이 전혀 도움X, 이것이 가장 큰 문제

10.3.2 Hierarchical Clustering . . . . . . . . . . . . . . . . . 390

10.3.3 Practical Issues in Clustering . . . . . . . . . . . . . 399

Gower Distance https://elecs.tistory.com/381

https://medium.com/analytics-vidhya/gowers-distance-899f9c4bd553

https://stat.ethz.ch/education/semesters/ss2012/ams/slides/v4.2.pdf

연속형과 범주형 변수가 혼합된 데이터의 군집분석 연구

https://www.kci.go.kr/kciportal/ci/sereArticleSearch/ciSereArtiView.kci?sereArticleSearchBean.artiId=ART002380072

- “범주의 일치 여부에 따라 0-1로 거리를 부여하는 Gower의 방법, 그리고 변수의 수준 개수 정보를 활용하는 Eskin의 방법 도입하여 혼합형 데이터에 거리를 측정할 수 있도록 군집 분석 결과를 비교하였다. 거리 정의 방법에 의존하지 않는 공정한 비교를 위해 세 가지 평가 측도를 이용하였다. 그 결과, 군집의 퍼짐 정도 및 군집 별 개체의 불균형한 상황에서 Eskin의 방법의 성능이 우수하였다. 또한, 군집의 응집성, 재현성, 군집의 개수 정확도 측면에서 Eskin의 방법이 더 나은 성능을 보였다.”

K-medoids clustering (PAM; Partitioning Around Medoids)

: 이전에 소개된 K-means clustering은 평균을 이용하기에 이상치(outlier)에 민감함

: PAM(Partitioning Around Medoids, 1987)는 평균 대신 대표주자(medoid)를 선택하고, 더 좋은 군집을 만드는 대표주자가 있으면 대체

: PAM은 K-means보다 강건한 방법(robust method)

: PAM은 소규모 자료 적용에는 유리하지만, 대규모 자료 적용에는 불안정(non-scalable)

출처: https://bioinformaticsandme.tistory.com/138 [BioinformaticsAndMe]

Silhouette 분석

- 효율적으로 잘 분리 됐다는 것은 다른 군집과의 거리는 떨어져 있고 동일 군집끼리의 데이터는 서로 가깝게 잘 뭉쳐 있다는 의미이다.

전체 실루엣 계수의 평균값, 즉 사이킷런읜 silhouette_score() 값은 0~1 사이의 값을 가지며, 1에 가까울 수록 좋다.

전체 실루엣 계수의 평균값과 더불어 개별 군집의 평균값의 편차가 작아야한다.

https://ariz1623.tistory.com/224

DBSCAN (Density-based spatial clustering of applications with noise)

- K Means나 Hierarchical 클러스터링의 경우 군집간의 거리를 이용하여 클러스터링을 하는 방법인데, 밀도 기반의 클러스터링은 점이 세밀하게 몰려 있어서 밀도가 높은 부분을 클러스터링 하는 방식이다. 쉽게 설명하면, 어느점을 기준으로 반경 x내에 점이 n개 이상 있으면 하나의 군집으로 인식하는 방식이다.

- K Means와 같이 클러스터의 수를 정하지 않아도 되며, 클러스터의 밀도에 따라서 클러스터를 서로 연결하기 때문에 기하학적인 모양을 갖는 군집도 잘 찾을 수 있으며 Noise point를 통하여, outlier 검출이 가능하다.

Neural Network

AutoEncoder

https://chioni.github.io/posts/ae/

https://atcold.github.io/pytorch-Deep-Learning/ko/week07/07-3/

https://excelsior-cjh.tistory.com/187#:~:text=%EC%98%A4%ED%86%A0%EC%9D%B8%EC%BD%94%EB%8D%94%20%2D%20Autoencoder,GRU%EC%97%90%20%EB%8C%80%ED%95%B4%20%EC%95%8C%EC%95%84%EB%B3%B4%EC%95%98%EB%8B%A4.

- 고차원 데이터의 Non Linear Dimensionality Reduction

- 선형(linear) 함수를 사용하고, 손실함수로 MSE(Mean Squared Error)를 사용할 경우에는 PCA라고 볼 수 있다.

- Anomaly Detection :

- 모델에 normal 데이터를 잔뜩 집어넣고 Reconstrucion Loss를 최소화하도록 업데이트한다

- 적절한 임계값을 설정하고 새로운 데이터의 에러가 임계값을 초과하면 Anomal Data로 분류한다

- 이미지 노이즈 제거image denoising, 이미지 압축기compressor

Recommender System

collaborative filtering

Review on BPR: Bayesian Personalized Ranking from Implicit Feedback, Rendle et al.

Statistics

CASE-CONTROL 에서는 Odds Ratio 써야 함

Why is relative risk not valid in case control studies?

: Using the contingency table notation in Wikipedia:

| Intervention (I) | Control (C) | |

| Events (E) | IE | CE |

| Non-events (N) | IN | CN |

- Odds Ratio=P(I∩E)/P(I∩N) / P(C∩E)/P(C∩N) = P(I|E)/P(I|N) / P(C|E)/P(C|N)

whereas

- Relative Risk=P(I∩E)/P(I) / P(C∩E)/P(C) = P(I|E)/P(I) / P(C|E)/P(C)

The key difference being, for odds ratio, one needs to know the conditional probabilities P(I|N),P(C|N), which are known in case control studies; whereas for relative risk, P(I),P(C) are not known from a retrospective study design.

통계학 도감

제1장 기술통계학

평균mean : 무게중심

중앙값median : 양쪽의 면적이 같은 확률변수 값

최빈값mode : 최빈

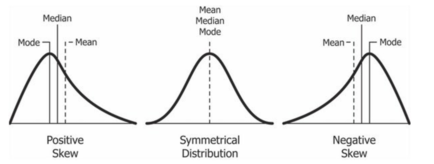

왜도skewness : $ E[( \frac{X - \mu}{\sigma} )^3] $

출처 : wikipedia https://en.wikipedia.org/wiki/Skewness

- > 0 : positive skewness, right skewed, 오른쪽 긴꼬리 — 평균보다 큰 X가 훨씬 많으니까 양수

- 최빈값 < 중앙값 < 평균

- 오른쪽 꼬리가 기니까, 최빈값보다 중앙값, 평균이 크다 : 오른쪽 꼬리가 길다 = 보이는 왼쪽부분보다 면적이 훨씬 크다는 점을 헷갈리지 않도록!

- 면적의 중간인 중앙값보다, 무게중심을 맞추기 위해서는 평균이 오른쪽으로 더 치우쳐져야 함 (ex. 시소)

- 소득분포를 생각해보자

- < 0 : negative skewness, 왼쪽 긴꼬리

※ 외우는 꿀팁 : mode 는 항상 직관적이니까, mode를 중심으로 median, mean 알파벳 순서로 외우면 됨. (방향만 혼동하지 않으면 됨)

첨도kurtosis : $ E( \frac{X - \mu}{\sigma} )^4 $

1.1 여러 가지 평균

1.2 데이터의 분산① 분위수와 분산

1.3 데이터의 분산② 변동계수

1.4 변수의 관련성① 상관계수

1.5 변수의 관련성② 순위상관

제2장 확률분포

2.1 확률과 확률분포

Probability Distributions

2.2 확률이 같은 분포 - 균일분포

2.3 동전 던지기의 분포 - 이항분포

이항분포, 초기하분포 관계

(→ 조건부, ←N극한)

https://m.blog.naver.com/mykepzzang/220839789774

2.4 종 모양의 분포 - 정규분포

2.5 척도가 없는 분포 - 표준정규분포

범위를 제한

https://en.wikipedia.org/wiki/Truncated_normal_distribution

2.6 데이터의 위치를 알 수 있다 - 시그마 구간

2.7 분포의 형태 - 왜도와 첨도

2.8 드물게 일어나는 분포 - 포아송 분포

2.9 여러 데이터를 동시에 취급하기 - x2 분포

2.10 x2 값의 비 - F 분포

2.11 정규분포 대신에 사용한다 - t 분포

제3장 추측통계학

3.1 표본으로 모집단의 특성을 파악한다 - 추측통계학

3.2 모수를 잘 대입한다 - 불편추정

3.3 제약을 받지 않는 데이터의 수 - 자유도

3.4 표본통계량의 분포① 평균의 분포

3.5 표본통계량의 분포② 비율의 분포

3.6 표본통계량의 분포③ 분산의 분포

3.7 표본통계량의 분포④ 상관계수의 분포

3.8 측정값과 참값의 차이 - 계통오차와 우연오차

3.9 표본평균에 관한 두 정리 - 대수의 법칙과 중심극한정리

30명이면 된다고? 회의에서 당당하게, 설문조사를 알아보자.

CLT for median

https://math.stackexchange.com/questions/2598143/median-of-large-numbers-of-gaussian-has-gaussian-distribution

Let X1,…,Xn be a random sample from a continuous PDf f(x) that is continuous and nonzero at the pth percentile xp,for 0<p<1.

If k/n→p (with k=np bounded), then the sequence of the kth order statistics Xk:n is asymptotically normal with

mean xp and variance c2/n, where c2=p(1−p)[f(xp)]2.

Notice that the theorem does not apply to the maximum or minimum.

https://osebje.famnit.upr.si/~russ.woodroofe/wustl-notes/CLT-medians.pdf

제4장 신뢰구간의 추정

4.1 폭을 갖게 한 추정① 모평균의 신뢰구간

4.2 폭을 갖게 한 추정② 모비율의 신뢰구간

4.3 폭을 갖게 한 추정③ 모분산의 신뢰구간

4.4 폭을 갖게 한 추정④ 모상관계수의 신뢰구간

4.5 시뮬레이션에서 모수를 추정한다 - 부트스트랩법

제5장 가설검정

Convergence of RV and Testing

5.1 차이가 있는지를 판정한다 - 가설검정

5.2 두 가설 - 귀무가설과 대립가설

5.3 가설검정 절차

5.4 특정 값(모평균)과 표본평균 검정

5.5 가설검정의 두 과오 - 제1종 과오와 제2종 과오

5.6 특정 값(모비율)과 표본비율 검정

5.7 특정 값(모분산)과 표본분산 검정

5.8 정말 상관관계가 있는가? - 무상관 검정

5.9 평균 차이 검정① 대응이 없는 두 집단의 경우

5.10 평균 차이 검정② 대응이 있는 두 집단의 경우

5.11 비율 차이 검정 - 대응이 없는 두 집단의 경우

5.12 뒤떨어지지 않음을 검증한다 - 비열성 시험

제6장 분산분석과 다중비교

6.1 실험으로 효과를 확인한다 - 일원배치 분산분석

6.2 여러 집단의 등분산검정 - 바트레트 검정

6.3 개체 차이를 고려한다 - 대응이 있는 일원배치 분산분석

6.4 교호작용을 찾아낸다 - 이원배치 분산분석

6.5 검정을 반복해서는 안 된다 - 다중성

6.6 반복할 수 있는 검정(다중비교법)① 본페로니법과 셰페법

6.7 반복할 수 있는 검정(다중비교법)② 튜키법과 튜키·크레이머법

6.8 반복할 수 있는 검정(다중비교법)③ 던넷법

FDR (False Discovery Rate)

https://ratsgo.github.io/machine%20learning/2017/05/07/FDR/

FDR은 제1종 오류를 최대한 적게 범하면서도 중요한 가설을 최대한 많이 찾을 수 있도록(H0 기각) 한다는 점이 강점입니다.

제7장 비모수 통계

7.1 분포에 의존하지 않는 검정 - 비모수 검정

7.2 질적 데이터의 검정 - 독립성 검정(피어슨의 x 2 검정)

독립성vs동질성 https://hsm-edu.tistory.com/1215?category=934374

우리의 '관점'과 '표본 추출 방법'에 의해 결정됩니다.

7.3 2×2 분할표 검정 - 피셔의 정확검정

binomial - hypergeometric https://m.blog.naver.com/mykepzzang/220839789774

exact test https://dermabae.tistory.com/175

7.4 대응이 없는 두 집단의 순서 데이터 검정 - 맨·휘트니의 U 검정

7.5 대응이 있는 두 집단의 순서 데이터 검정 - 부호검정

7.6 대응이 있는 두 집단의 양적 데이터 비모수 검정 윌콕슨의 부호순위검정

7.7 대응이 없는 여러 집단의 순서 데이터 검정 크러스컬·월리스 검정

7.8 대응이 있는 여러 집단의 순서 데이터 검정 - 프리드먼 검정

제8장 실험계획법

8.1 피셔의 3원칙① 반복

8.2 피셔의 3원칙② 무작위화

8.3 피셔의 3원칙③ 국소관리

8.4 여러 가지 실험 배치

8.5 실험을 간추려 실시한다 - 직교계획법

8.6 직교계획법의 응용① 품질공학(파라미터 설계)

8.7 직교계획법의 응용② 컨조인트 분석

8.8 표본 크기를 정하는 법 - 검출력 분석

제9장 회귀분석

9.1 원인과 결과의 연관을 찾는다 - 회귀분석

9.2 데이터에 수식을 동일하게 적용한다 - 최소제곱법

9.3 회귀선의 정확도를 평가한다 - 결정계수

9.4 회귀선의 기울기를 검정한다 - t 검정

9.5 분석의 적절성을 검토한다 - 잔차분석

9.6 원인이 여럿일 때의 회귀분석 - 중회귀분석

9.7 설명변수 간의 문제 - 다중공선성

9.8 유효한 설명변수를 고른다 - 변수선택법

9.9 질의 차이를 설명하는 변수① 절편 더미

9.10 질의 차이를 설명하는 변수② 기울기 더미

9.11 더미변수를 이용한 회귀분석 - 프로빗 분석

9.12 사건 발생까지의 시간을 분석한다① 생존곡선

9.13 사건 발생까지의 시간을 분석한다② 생존곡선의 비교

9.14 사건 발생까지의 시간을 분석한다③ Cox 비례 해저드 회귀

제10장 다변량 분석

10.1 정보를 수집한다 - 주성분분석

10.2 잠재적인 요인을 찾는다 - 인자분석

10.3 인과 구조를 기술한다 - 구조 방정식 모델링(SEM)

10.4 개체를 분류한다 - 클러스터 분석

10.5 질적 데이터의 관련성을 분석한다 - 코레스폰던스 분석

제11장 베이즈 통계학과 빅데이터

11.1 지식과 경험을 살릴 수 있는 통계학 - 베이즈 통계학

11.2 만능의 식 - 베이즈 정리

11.3 결과에서 거슬러 올라가 원인을 찾는다 - 사후확률

11.4 새로운 데이터로 더 정확하게 - 베이즈 갱신

11.5 빅데이터 분석① 빅데이터

11.6 빅데이터 분석② 연관성 분석

11.7 빅데이터 분석③ 트렌드 예측과 SNS 분석

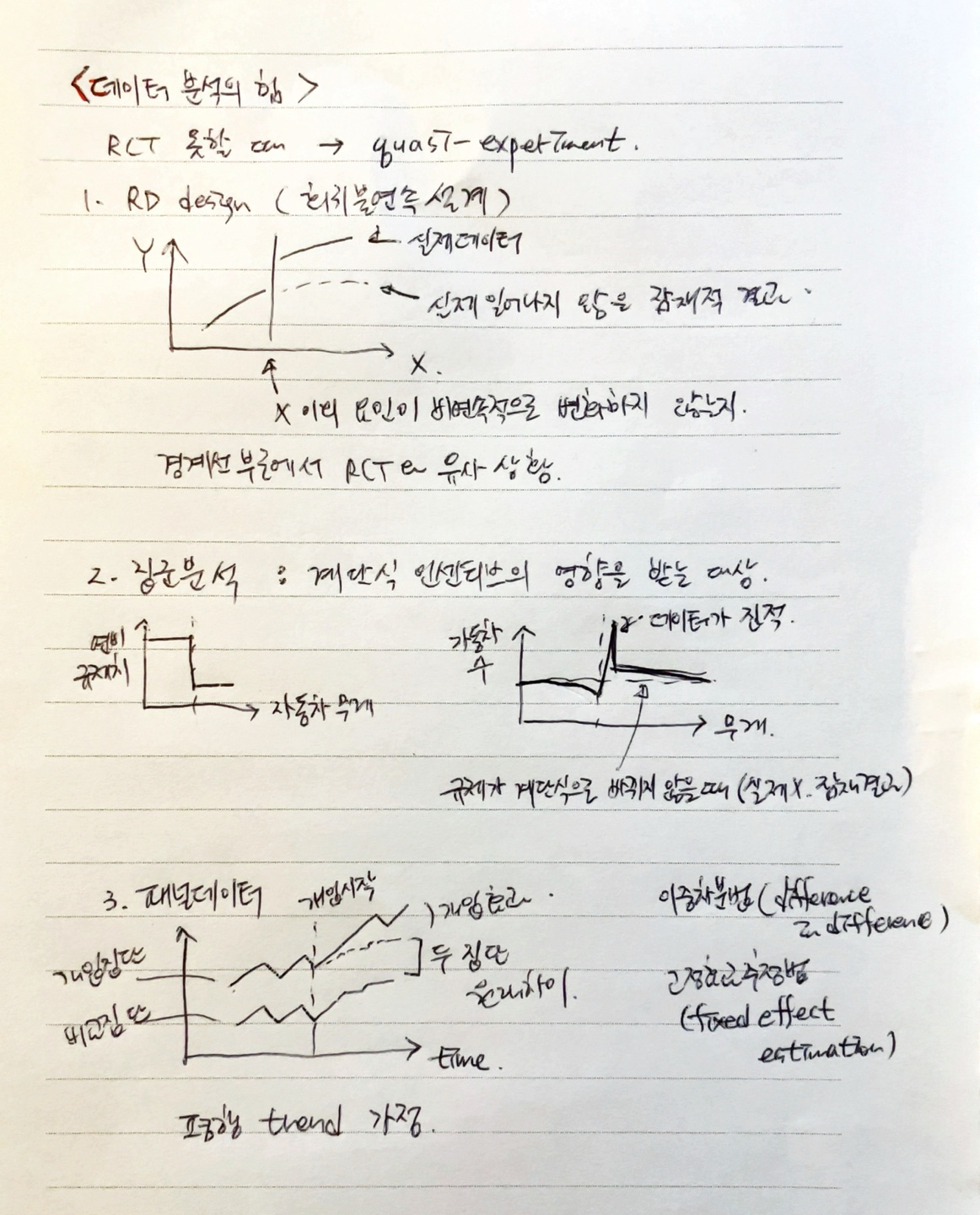

Causal Inference

Instrumental Variable https://danbi-ncsoft.github.io/study/2019/08/07/IV.html

Propensity Scoring matching https://greend93.tistory.com/3

References

1. Doing Data Science

OLD

-

- 강의자료들..

-

- 넘버웍스가 작년(2015년 12월)에 채용할 때 입사 지원자분들에게 드렸던 메일입니다.

- 빅 데이터(기계학습/패턴분석)의 수학적 이해를 위한 책들 - 성균관대 수학과 교수 정윤모

-

- 통계의 기본적인 개념들을 시각적/실험적 으로 보여줌

-

- 보건통계?

연대 강의자료 정리하기

Testing

FWER, FDR 2 Bonferroni_correction

A-B Testing의 단점과 개선안 https://en.wikipedia.org/wiki/Multi-armed_bandit

Uplift Modeling : 무작위 대조시험과 고객 정보로 부터 추출한 특징을 조합하여, 효과가 좋은 고객을 예측해주는 모델을 구축하는 기법입니다. 이 기법을 사용하면 비용을 절감하고 효과를 최대화 할 수 있습니다.

Cohen's Kappa Coefficient : 우연히 일치할 가능성을 고려한 기준 (채점, Training 데이터 수작업의 난이도?)

Rubin Causal Model 한글 : Causal Inference, 근본적으로 실험/통제에 대한 두 값을 모두 얻을 수는 없음

Mathematics

-

- 중등수학 이상의 수학 지식들을 위키에 정리한 것.

-

- 수학 공식들의 증명을 모아놓은 위키. 자세한 증명들이 나와있다.

Probability

https://forums.alina.ai/t/probability-distribution/103?u=thoh

Zipf's law : 어떠한 자연어 말뭉치 표현에 나타나는 단어들을 그 사용 빈도가 높은 순서대로 나열하였을 때, 모든 단어의 사용 빈도는 해당 단어의 순위에 반비례한다. 따라서 가장 사용 빈도가 높은 단어는 두 번째 단어보다 빈도가 약 두 배 높으며, 세 번째 단어보다는 빈도가 세 배 높다.

Bayesian

Neural Network/Deep Learning

- Neural Network

- Back Propagation : Chain rule로 Gradient를 계산함 실제 숫자 예제

-

- This paper is a review of the evolutionary history of deep learning models.

Dimension reduction

Recommend System

NLP

Mathematics

-

- 중등수학 이상의 수학 지식들을 위키에 정리한 것.

-

- 수학 공식들의 증명을 모아놓은 위키. 자세한 증명들이 나와있다.

Probability

https://forums.alina.ai/t/probability-distribution/103?u=thoh

Zipf's law : 어떠한 자연어 말뭉치 표현에 나타나는 단어들을 그 사용 빈도가 높은 순서대로 나열하였을 때, 모든 단어의 사용 빈도는 해당 단어의 순위에 반비례한다. 따라서 가장 사용 빈도가 높은 단어는 두 번째 단어보다 빈도가 약 두 배 높으며, 세 번째 단어보다는 빈도가 세 배 높다.

Bayesian

Neural Network/Deep Learning

- Neural Network

- Back Propagation : Chain rule로 Gradient를 계산함 실제 숫자 예제

-

- This paper is a review of the evolutionary history of deep learning models.

Dimension reduction

Recommend System

NLP

Survey

https://www.surveymonkey.com/mp/sample-size-calculator/

~~ Sampling from Finite Populations : finite population correction (fpc) factor = sqrt( N-n / N-1 )

Discussion